admin

169

0

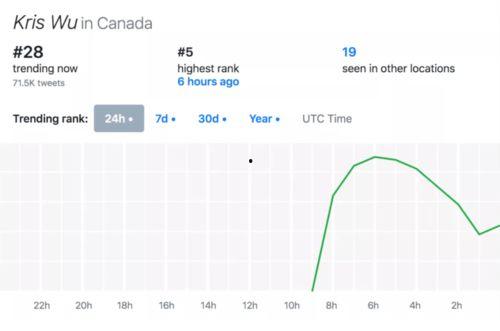

亲爱的读者们,最近有没有被娱乐圈的八卦新闻刷屏呢?今天,我就要来给你揭秘今年那些让人忍不住吃瓜的明星们,看看他们是如何在娱乐圈中掀起一阵阵热潮的!一、影视界的“瓜王”今年的影视圈可谓是热闹非凡,不少作品都收获了超高评分。其中,一部由当红小生和小花旦主演的电视剧,可谓是今年的“瓜王”。这部剧自开播以来,不仅剧情跌宕起伏,人物关系错综复杂,更是时不时地爆出一些让人意想不到的“瓜”。比如,剧中某位女主角竟然在片场与导演发生了争执,导致拍摄中断。还有,男主角在拍摄...

admin

170

0

说到孙悟空吃瓜子的梗,那可真是让人忍俊不禁啊!你有没有想过,这个看似普通的搞笑桥段,背后竟然有着深厚的历史背景和文化内涵呢?今天,就让我带你一探究竟,揭开这个梗的神秘面纱吧!一、孙悟空吃瓜子的梗从何而来?说起孙悟空吃瓜子的梗,不得不提一部经典的电视剧——《西游记》。在这部剧中,孙悟空的形象深入人心,他不仅有着神通广大的法力,还有着独特的个性。而在剧中,孙悟空吃瓜子的场景更是让人印象深刻。据资料显示,这个梗最早出现在《西游记》第五回“孙悟空大闹天宫”中。当时...

admin

173

0

娱乐圈吃瓜蜀黍是谁?亲爱的读者们,你是否在娱乐圈的新闻中,总是看到一个神秘的身影,他似乎无所不知,对娱乐圈的八卦了如指掌?没错,今天咱们就来揭秘这位神秘人物——娱乐圈吃瓜蜀黍究竟是谁!一、娱乐圈吃瓜蜀黍的来历娱乐圈吃瓜蜀黍,这个名字听起来就让人忍不住想笑。这位神秘人物,最初在网络上以“娱乐圈吃瓜群众”的身份出现,后来逐渐演变成“娱乐圈吃瓜蜀黍”。他自称是娱乐圈的“情报员”,每天都会在微博、知乎等社交平台上分享娱乐圈的最新动态。二、娱乐圈吃瓜蜀黍的“战绩”娱...

admin

169

0

娱乐圈的八卦风云,总是让人忍不住想要一探究竟。而在这个信息爆炸的时代,百度网盘成了许多“吃瓜群众”的读心术,让我们得以窥见那些明星背后的故事。今天,就让我们一起揭开娱乐圈的神秘面纱,用百度网盘的“读心术”来一探究竟吧!一、百度网盘:娱乐圈的“读心术”百度网盘,作为国内最大的云存储平台,不仅方便了我们的生活,更成了娱乐圈八卦的聚集地。在这里,你可以找到各种明星的私密照片、视频,甚至是一些独家访谈和幕后花絮。而这些内容,往往能让我们窥见明星们不为人知的一面。二...

admin

169

0

亲爱的读者们,今天我要给大家带来一个超级劲爆的娱乐八卦故事,让你这个周末不再无聊!没错,我要说的就是那位人称“娱乐吃瓜哥”的神秘人物。他可是娱乐圈的“福尔摩斯”,总能第一时间挖出明星们的料,让人大呼过瘾。下面就让我带你一起走进他的世界,看看他是如何成为娱乐圈的“吃瓜达人”的吧!一、初露锋芒,成为“吃瓜哥”“娱乐吃瓜哥”本名李明,一个普通的90后青年。他从小就对娱乐圈充满好奇,喜欢看各种明星八卦。大学毕业后,他进入了一家互联网公司,负责运营一个娱乐类公众号。...

admin

403

0

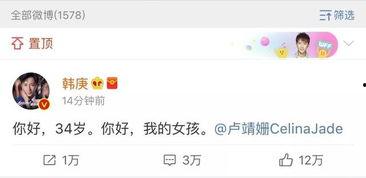

亲爱的读者们,你是不是也和我一样,每天忙碌之余,总想找点乐子,放松一下紧绷的神经呢?那就跟着我一起,来一场说走就走的“娱乐吃瓜”之旅吧!在这个信息爆炸的时代,娱乐圈的瓜可是层出不穷,今天,我们就来聊聊那些让人笑掉大牙、哭笑不得的娱乐新闻。瓜田里的“明星夫妻”说到娱乐圈的瓜,怎么能不提那些明星夫妻呢?他们的一举一动都牵动着无数粉丝的心。比如,最近某对明星夫妻因为家庭琐事闹上了热搜,网友们纷纷化身“侦探”,挖掘出各种细节,从他们的微博互动到私下聚会,都被翻了个...

admin

171

0

你知道吗?最近娱乐圈可是热闹非凡,尤其是那些直播间的“吃瓜群众”们,简直就像是在开一场盛大的八卦盛宴。今天,我就来给你揭秘一下那些让人瞠目结舌的娱乐主播八卦爆料,让你一次性过足瘾!一、直播间的“瓜王”诞生记说起直播间的八卦,不得不提的就是那位被称为“瓜王”的主播。他(她)可是拥有着海量独家爆料,每次开播都能引来无数粉丝围观。据不完全统计,这位“瓜王”已经成功爆料了超过50个娱乐圈大事件,其中不乏一些明星的隐私和幕后故事。有一次,他在直播中透露,某位当红明星...

admin

401

0

娱乐时间到,吃瓜群众狂欢啦!亲爱的读者们,是不是又到了你我最爱的娱乐时间呢?没错,今天我们要聊的话题就是——吃瓜!在这个信息爆炸的时代,娱乐圈的瓜可是层出不穷,让人应接不暇。那么,就让我们一起坐下来,边吃瓜边享受这美好的时光吧!娱乐圈的“瓜王”盘点首先,让我们来盘点一下那些让人津津乐道的“瓜王”。近年来,娱乐圈的瓜可谓是层出不穷,其中不乏一些让人瞠目结舌的事件。以下是一些备受关注的“瓜王”:1. 明星恋情曝光:每当有明星恋情曝光,都会引起网友们的热议。比如...

admin

404

0

亲爱的读者们,今天我要给你带来一篇超级有趣的文章,让你在忙碌的生活中找到一丝轻松的乐趣。你知道嘛,在这个信息爆炸的时代,我们每天都被各种新闻、八卦包围着。今天,我就要带你走进一个充满笑声和八卦的世界——小乔的吃瓜娱乐大揭秘!小乔的吃瓜日常小乔,一个典型的90后女孩,对娱乐圈的动态了如指掌。她每天都会花费大量的时间在各种社交媒体上浏览各种娱乐新闻,然后和朋友们一起分享、讨论。她的吃瓜日常,可谓是丰富多彩。1. 微博热搜每天早上,小乔的第一件事就是打开微博,查...

admin

629

0

你有没有想过,如果有一种神奇的系统,能让你瞬间读懂娱乐圈那些明星的心思,那该多好玩啊!没错,今天就要来聊聊这个让人兴奋的“读心吃瓜系统”。想象你坐在沙发上,一杯果汁在手,就能轻松解锁明星们的内心世界,是不是很心动?一、读心吃瓜系统的诞生这个神奇的系统,其实源于我们对娱乐圈的好奇心。随着互联网的快速发展,我们每天都能看到各种明星的新闻,但往往只能看到他们想让我们看到的。那么,他们真实的想法是什么呢?于是,聪明的程序员们就发明了“读心吃瓜系统”。这个系统的工作...