大数据运维(Big Data Operations)是指对大数据渠道进行保护、监控、优化和保证其安稳运转的一系列作业。它涵盖了大数据渠道从布置、运转到保护的整个进程,保证大数据体系可以高效、安全地处理和剖析数据。

大数据运维的首要作业内容包含:

1. 体系布置与装备:担任大数据渠道的装置、装备和初始化,包含硬件资源、软件环境和数据存储等。

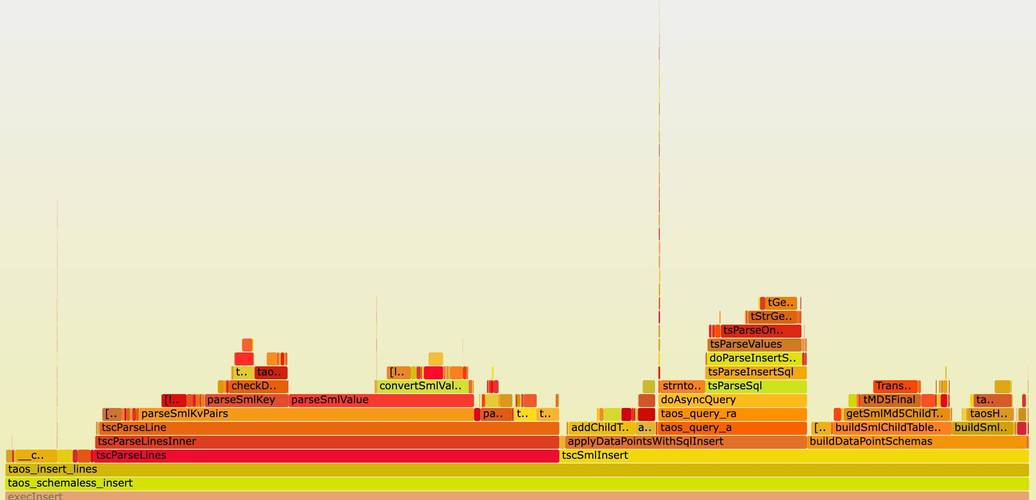

2. 功能监控与优化:实时监控大数据渠道的运转状况,包含CPU、内存、磁盘I/O、网络流量等目标,及时发现并处理功能瓶颈。

3. 毛病排查与康复:当大数据渠道呈现毛病时,快速定位问题并进行修正,保证体系的连续性和安稳性。

4. 数据备份与康复:拟定并履行数据备份战略,保证数据的安全性和可康复性。

5. 安全办理:担任大数据渠道的安全防护,包含用户权限办理、数据加密、拜访操控等,避免数据走漏和未授权拜访。

6. 资源办理与调度:合理分配和办理大数据渠道的核算、存储和网络资源,进步资源运用率。

7. 日志剖析与审计:搜集和剖析大数据渠道的运转日志,用于问题排查、功能优化和安全审计。

8. 自动化运维:运用自动化东西和脚本,完成大数据渠道的自动化布置、监控和运维,进步运维功率。

9. 继续集成与继续布置:与开发团队协作,完成大数据渠道的继续集成和继续布置,保证体系的快速迭代和更新。

10. 训练与支撑:为大数据渠道的用户和开发者供给训练和技能支撑,协助他们更好地运用和运维大数据渠道。

大数据运维是一个触及多个范畴的综合性作业,需求具有厚实的技能根底、丰厚的运维经历和杰出的问题处理才能。跟着大数据技能的不断发展,大数据运维的重要性也越来越杰出,成为保证大数据渠道安稳运转的关键环节。

大数据运维,即大数据环境下的运维作业,是指在大数据技能架构下,对大数据渠道、体系、使用等进行监控、保护、优化和毛病处理的一系列作业。跟着大数据技能的广泛使用,大数据运维成为了保证大数据体系安稳运转的关键环节。

大数据运维的作业内容首要包含以下几个方面:

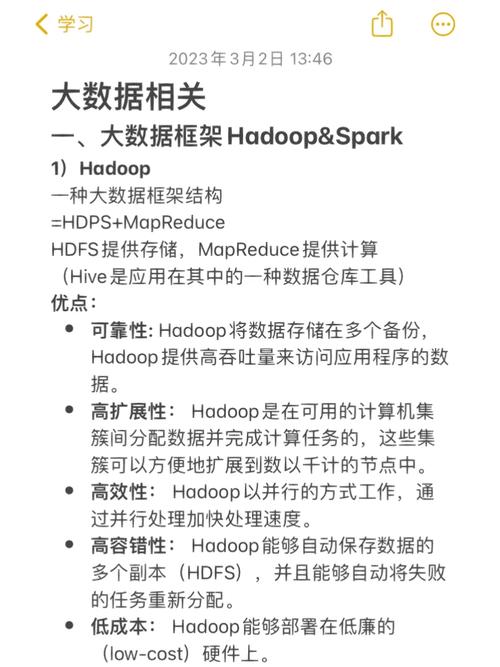

大数据运维工程师需求具有以下技能:

跟着大数据技能的不断发展,大数据运维在各个职业中的使用越来越广泛。以下是大数据运维的发展前景:

大数据运维作为大数据技能范畴的重要组成部分,其作业内容丰厚,技能要求较高。跟着大数据技能的不断发展,大数据运维工程师在各个职业中的使用越来越广泛,发展前景非常看好。关于有志于从事大数据运维作业的朋友来说,这是一个充溢挑战和机会的职业选择。

下一篇: 创立mysql数据库,从根底到实践