1. Requests:一个简略易用的HTTP库,用于发送HTTP恳求。它支撑多种协议,如HTTP、HTTPS等。

2. BeautifulSoup:一个用于解析HTML和XML文档的库,能够方便地从网页中提取所需的数据。

3. Scrapy:一个强壮的网络爬虫结构,它供给了许多功用,如恳求调度、数据提取、数据存储等。Scrapy支撑多种爬虫战略,如广度优先查找、深度优先查找等。

4. Selenium:一个用于Web运用程序测验的东西,但它也能够用于爬虫开发。Selenium能够模仿浏览器行为,如点击、输入等,然后获取动态生成的内容。

5. Lxml:一个依据libxml2的Python库,用于解析XML和HTML文档。它比BeautifulSoup更快,但需求额定的依靠。

6. PyQuery:一个类似于jQuery的Python库,用于解析HTML文档。它供给了一个简略易用的API,用于查询和操作HTML元素。

7. RobotParser:一个用于解析robots.txt文件的库,它能够协助爬虫恪守网站的爬虫战略。

8. Aiohttp:一个异步HTTP客户端/服务端结构,用于异步爬虫开发。它支撑异步恳求和呼应处理,能够进步爬虫的功率。

9. ScrapyRedis:一个Scrapy扩展,用于完成分布式爬虫。它运用Redis作为音讯行列,支撑多台机器协同作业。

10. PySelenium:一个用于Selenium的Python封装库,它供给了更简略易用的API,用于模仿浏览器行为。

11. ScrapyWebdriver:一个Scrapy扩展,用于与Selenium集成。它答应Scrapy运用Selenium作为下载器,以获取动态内容。

12. ScrapySplash:一个Scrapy扩展,用于与Splash集成。Splash是一个JavaScript烘托服务,能够处理动态内容和杂乱的页面交互。

13. ScrapyRedisBloomFilter:一个Scrapy扩展,用于完成布隆过滤器,以防止重复恳求相同的URL。

14. ScrapyUserAgent:一个Scrapy扩展,用于随机化用户署理,以防止被网站封闭。

15. ScrapyImages:一个Scrapy扩展,用于下载和存储图画。

16. ScrapyJson:一个Scrapy扩展,用于解析JSON呼应。

17. ScrapyCSV:一个Scrapy扩展,用于解析CSV呼应。

18. ScrapyXML:一个Scrapy扩展,用于解析XML呼应。

19. ScrapyPostgres:一个Scrapy扩展,用于将数据存储到PostgreSQL数据库。

20. ScrapyMongoDB:一个Scrapy扩展,用于将数据存储到MongoDB数据库。

这些库和东西能够依据你的详细需求进行挑选和组合,以创立一个高效、牢靠的爬虫体系。请留意,爬虫开发需求恪守相关法律法规和网站方针,防止对网站形成不良影响。

爬虫,全称为网络爬虫,是一种主动获取网页内容的程序。它经过模仿浏览器行为,拜访网站并提取所需数据。爬虫在查找引擎、数据剖析、舆情监测等范畴有着广泛的运用。

语法简练,易于学习

丰厚的库支撑,如requests、BeautifulSoup、Scrapy等

强壮的数据处理才能,如Pandas、NumPy等

杰出的社区支撑,易于解决问题

进行Python爬虫开发,一般需求以下根本过程:

确认方针网站和数据类型

剖析网站结构,获取数据URL

编写爬虫代码,模仿浏览器行为

解析网页内容,提取所需数据

存储数据,如CSV、数据库等

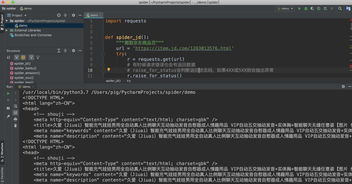

以下是一个简略的Python爬虫事例,用于爬取豆瓣电影Top250的数据。

import requests

from bs4 import BeautifulSoup

def get_movie_list(url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

movie_list = soup.find_all('div', class_='hd')

movies = []

for movie in movie_list:

title = movie.find('a').text

rating = movie.find('span', class_='rating_num').text

movies.append({'title': title, 'rating': rating})

return movies

if __name__ == '__main__':

url = 'https://movie.douban.com/top250'

movies = get_movie_list(url)

for movie in movies:

print(movie)

在进行Python爬虫开发时,需求留意以下事项:

恪守法律法规和网站运用条款

尊重网站robots.txt文件规则

合理设置爬取频率,防止对网站形成过大压力

处理异常情况,如网络过错、数据解析过错等

Python爬虫是一种强壮的数据获取东西,能够协助咱们快速获取互联网上的信息。经过本文的介绍,信任您现已对Python爬虫有了开始的了解。在实践运用中,不断堆集经历,进步爬虫技术,将有助于您在数据剖析和研讨等范畴获得更好的效果。