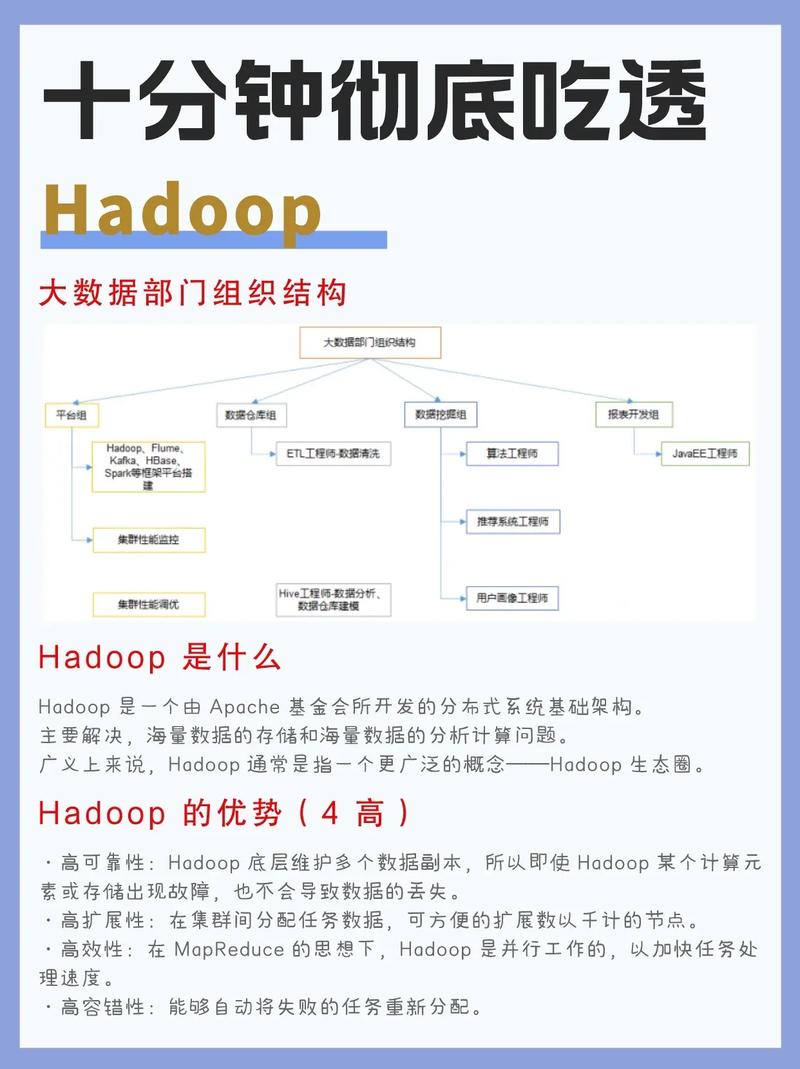

Hadoop是一个开源的散布式核算结构,它答运用户在大规模集群上存储和处理大数据。Hadoop由Apache软件基金会开发,首要包含两个中心组件:Hadoop Distributed File System(HDFS)和Hadoop MapReduce。

1. HDFS(Hadoop Distributed File System)是一个高吞吐量的散布式文件体系,它规划用来存储很多数据,而且运行在低成本的硬件上。HDFS供给了数据的容错机制,经过在多个节点上仿制数据来确保数据的可靠性。

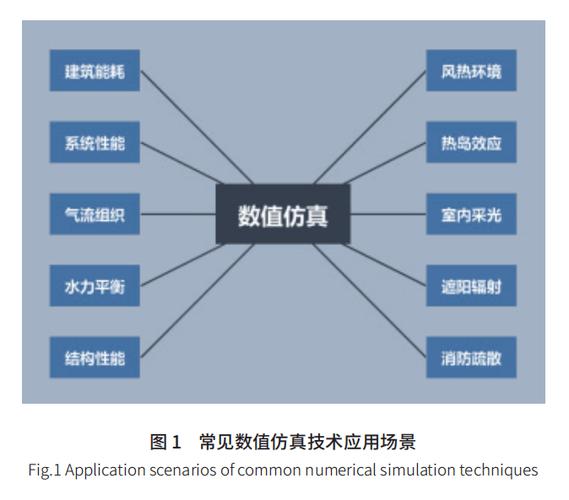

Hadoop广泛运用于各种大数据处理场景,如日志剖析、数据发掘、机器学习等。因为其可扩展性和容错性,Hadoop已经成为大数据处理范畴的事实标准。

Hadoop是由Apache软件基金会开发的一个开源结构,旨在处理海量数据。它答应在很多一般硬件上以散布式并行的方法处理大规模数据集。Hadoop的中心规划理念是将大数据分割成许多小的数据块,散布存储在集群中的不同节点上,然后经过散布式核算结构对这些数据进行处理和剖析。

Hadoop架构首要包含以下几个中心组件:

HDFS (Hadoop Distributed File System):散布式文件体系,用于存储大规模数据。

MapReduce:散布式核算结构,用于在Hadoop集群上并行处理数据。

YARN (Yet Another Resource Negotiator):资源办理器,担任集群资源的办理和调度。

Hive:SQL言语查询引擎,依据HiveQL供给类SQL的查询方法,适用于批量数据剖析。

HBase:散布式列存储体系,用于存储很多结构化数据。

Pig:数据流式处理渠道,相似SQL,但更适合大数据的批处理使命。

日志剖析:经过对海量日志数据进行处理和剖析,企业能够了解用户行为、体系功能等信息,然后优化产品和服务。

交际网络剖析:经过剖析交际网络数据,企业能够了解用户联系、爱好等,然后进行精准营销和用户画像构建。

金融风控:经过对金融交易数据进行实时剖析,金融机构能够辨认潜在危险,下降金融危险。

智能交通:经过对交通数据进行实时剖析,政府和企业能够优化交通办理,进步交通功率。

合理装备集群资源:依据实践需求,合理装备集群中的节点数量、内存、CPU等资源。

优化数据存储:合理区分数据块巨细,进步数据读写功率。

优化MapReduce使命:合理规划MapReduce使命,进步并行处理才能。

运用高效的数据格式:如Parquet、ORC等,进步数据存储和读取功率。

跟着大数据技能的不断发展,Hadoop在未来将出现以下发展趋势:

更高效的数据处理才能:跟着硬件功能的提高和算法的优化,Hadoop的数据处理才能将得到进一步提高。

更广泛的运用场景:Hadoop将在更多范畴得到运用,如物联网、人工智能等。

更快捷的运用方法:跟着Hadoop生态体系的不断完善,用户将愈加方便地运用Hadoop进行数据处理。

Hadoop作为大数据年代的柱石,为企业和安排供给了强壮的数据处理才能。跟着技能的不断发展,Hadoop将在未来发挥愈加重要的效果。了解Hadoop的中心概念、架构和运用场景,关于大数据从业者和爱好者来说具有重要意义。